对于单个的 RNNCell , 使用色的 call 函数进行运算时 ,只是在序列时间上前进了一步 。

如使用 x1、 ho 得到此h1, 通过 x2 、 h1 得到 h2 等 。

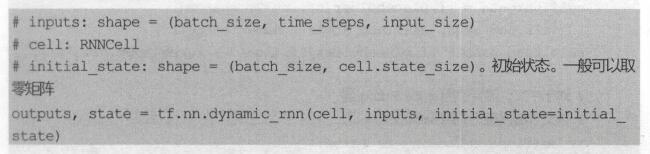

tf.nn.dynamic_rnn的作用:

如果序列长度为n,要调用n次call函数,比较麻烦。对此,TensorFlow提供了一个tf.nn.dynamic_mn函数,使用该函数相当于调用了n次call函数。通过{ho, x1 , x2,…, xn} 直接得到{h1 , h2,…, hn} 。

具体来说,设输入数据的格式为(batch_size, time_steps, input size),

其中batch_size表示batch的大小,即包含几个序列。

time_steps表示序列长度,

input_size表示输入数据单个序列单个时间维度上固有的长度。

此时,得到的outputs是time_steps步里所有的输出。它的形状为(batch_size, time_steps, cell.output size)。state 是最后一步的隐状态,形状为(batch_size, cell . state_size) 。

至此,在对每一步的输出进行变换,可以得到损失并进行训练模型了。

以上这篇使用 tf.nn.dynamic_rnn 展开时间维度方式就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持python博客。

-

<< 上一篇 下一篇 >>

使用 tf.nn.dynamic_rnn 展开时间维度方式

看: 1224次 时间:2020-10-28 分类 : python教程

- 相关文章

- 2021-12-20Python 实现图片色彩转换案例

- 2021-12-20python初学定义函数

- 2021-12-20图文详解Python如何导入自己编写的py文件

- 2021-12-20python二分法查找实例代码

- 2021-12-20Pyinstaller打包工具的使用以及避坑

- 2021-12-20Facebook开源一站式服务python时序利器Kats详解

- 2021-12-20pyCaret效率倍增开源低代码的python机器学习工具

- 2021-12-20python机器学习使数据更鲜活的可视化工具Pandas_Alive

- 2021-12-20python读写文件with open的介绍

- 2021-12-20Python生成任意波形并存为txt的实现

-

搜索

-

-

推荐资源

-

Powered By python教程网 鲁ICP备18013710号

python博客 - 小白学python最友好的网站!